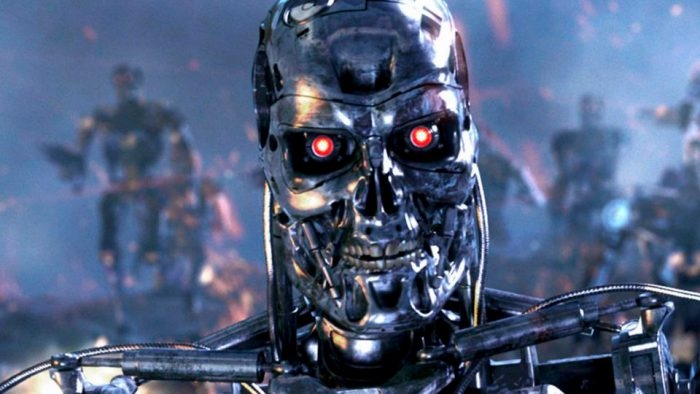

Já vimos armas robóticas se transformando em ameaça à humanidade, mas nos cinemas. O assunto foi retratado numerosas vezes nos estúdios de Hollywood, com O Exterminador do Futuro sendo o exemplo mais emblemático, provavelmente. Mas, para 116 líderes (incluindo Elon Musk) em inteligência artificial, robótica e afins, o risco de equipamentos avançados de combate saírem do controle e causarem grandes estragos é real. Essas máquinas não são formadas necessariamente por robôs com aspecto humanoide, como costumamos imaginar, mas por drones, embarcações não tripuladas, disparadores móveis de mísseis e assim por diante. Os principais exércitos do mundo — com destaque para as forças militares dos Estados Unidos — trabalham há algum tempo no desenvolvimento de tecnologias que permitirão que máquinas ataquem inimigos de modo eficaz, mas sem intervenção humana. É o caso, por exemplo, do caça não tripulado X-47B, que pode ser reabastecido no ar e decolar de porta-aviões. Essa aeronave está praticamente aposentada, mas a sua tecnologia deverá ser empregada em outros modelos, como o sucessor X-47C, a ser fabricado em 2018.

Outro exemplo é o Sea Hunter, embarcação com cerca de 40 metros de comprimento que pode se deslocar por mais de 18 mil quilômetros de maneira autônoma. O navio ainda está em testes, mas vem sendo preparado para cumprir missões sem a presença de militares a bordo. Para os líderes, é aí que mora o perigo. Eles temem, por exemplo, o risco de a inteligência das máquinas decidir erroneamente que determinado território deve ser atacado. O alvo pode entender o ataque como uma decisão deliberada daquele exército e, então, revidar. Aí o caos começa de vez. Note que não estamos falando de uma revolta das máquinas para destruir a humanidade, tal como Hollywood retrata, mas de uma decisão indevida oriunda de limitações, falhas ou invasões ao sistema que controla as máquinas.

O grupo adverte que o desenvolvimento da inteligência artificial está avançando tanto que é questão de anos — e não décadas — para as armas robóticas estarem prontos para combater. Os líderes pedem que a ONU proíba a criação desse tipo de tecnologia antes que seja tarde: “não teremos tempo suficiente para intervir; quando essa Caixa de Pandora for aberta, será difícil fechá-la”, alertam. Exagero? Pode até ser, mas o assunto começa a chamar atenção das autoridades. A carta foi publicada durante a abertura do IJCAI, congresso sobre inteligência artificial que está sendo realizado na Austrália. Mas a ideia inicial era dar o alerta em um encontro na ONU que discutiria o uso de armas autônomas letais nesta segunda-feira (21). Só não foi porque o evento foi adiado para novembro. Além de Elon Musk, outro nome que se destaca no grupo de 116 líderes é o de Mustafa Suleyman, cofundador da Deepmind, companhia adquirida pelo Google que, hoje, atua como a divisão de inteligência artificial da Alphabet. Com informações: The Guardian